Questo articolo adotta un taglio esclusivamente tecnico e si rivolge a professionisti IT, security engineer, SOC analyst e decisori tecnologici. L’obiettivo non è sensazionalistico, ma comprendere l’architettura, il modello operativo e le implicazioni difensive di DIG AI, un servizio di intelligenza artificiale emerso nel circuito darknet.

Le informazioni qui riportate derivano da analisi OSINT e da quanto pubblicato da Resecurity, integrato con valutazioni architetturali e threat modeling.

1. Posizionamento di DIG AI nel panorama LLM underground

DIG AI si colloca nella nuova generazione di Criminal LLM (C-LLM), sistemi progettati o adattati per:

assenza totale di policy di sicurezza (no alignment, no RLHF)

eliminazione dei filtri su contenuti illegali

accesso anonimo e non tracciabile

output orientato all’uso operativo

A differenza di FraudGPT o WormGPT, che seguivano un modello SaaS criminale (abbonamento + autenticazione), DIG AI adotta un modello open-access su hidden service.

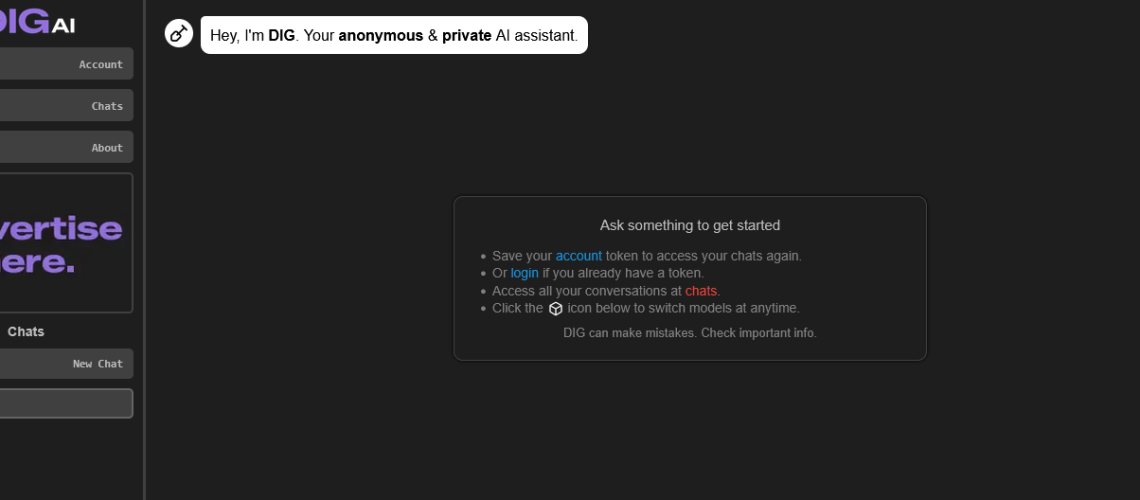

2. Accesso e superficie di esposizione

Accesso

Disponibile esclusivamente come hidden service su rete Tor

Nessuna autenticazione

Nessun sistema di rate limit noto

Nessun sistema di logging lato utente dichiarato

Implicazioni

Impossibilità di attribution (no user ID, no payment trail)

Ampia superficie d’uso anche per low-skill attackers

Difficoltà di takedown coordinato (assenza di provider cloud noti)

3. Architettura ipotizzata del sistema

Sulla base del comportamento osservato, DIG AI sembra seguire una struttura simile:

[ Tor Hidden Service ]

|

[ Prompt Handler / Router ]

|

[ LLM Core ]

| |

[Model A] [Model B] [Model C]

|

[ Output Formatter ]

Elementi chiave:

Prompt routing su più modelli (l’amministratore dichiara 3 modelli)

Nessun content inspection layer

Nessun moderation endpoint

Output diretto verso l’utente

L’affermazione secondo cui uno dei modelli sarebbe “basato su ChatGPT Turbo” va interpretata con cautela:

più realisticamente si tratta di fine-tuning illecito, model distillation o reverse prompting su modelli open-weight.

4. Capacità funzionali osservate

Durante i test riportati:

Malware & offensive code

Generazione di:

backdoor persistenti

loader PowerShell / Bash

script di esfiltrazione dati

Codice:

sintatticamente corretto

funzionalmente eseguibile

con logica di evasione di base

⚠️ Nota tecnica: il valore non è nella “qualità assoluta” del malware, ma nella riduzione drastica del tempo di sviluppo.

5. DIG AI come moltiplicatore di minaccia

Dal punto di vista del threat modeling, DIG AI introduce tre acceleratori critici:

1. Abbattimento della barriera tecnica

Attori non esperti possono:

generare payload

adattare codice

comprendere tool offensivi

2. Automazione cognitiva

Il sistema:

spiega il codice che genera

risponde a follow-up

corregge errori su richiesta

3. Scalabilità dell’abuso

Un singolo attore può:

testare decine di varianti

adattare attacchi a target diversi

iterare rapidamente

6. Aspetto più critico: generazione e trasformazione di contenuti illegali

Dal punto di vista tecnico, il sistema dimostra:

capacità di image-to-image transformation

assenza di classifier NSFW

assenza di controlli su input sensibili

Questo implica l’uso (o l’integrazione) di:

modelli generativi multimodali

pipeline di post-processing

assenza totale di safety layers

Per la sicurezza globale, questo è un red flag assoluto: non siamo davanti a misuse accidentale, ma a design intenzionale.

7. Limiti prestazionali e indicazioni infrastrutturali

Alcuni prompt richiedono tempi lunghi (minuti):

Indicazioni tecniche:

GPU limitate o condivise

batch processing

assenza di autoscaling

Ma:

introduzione di modelli a pagamento

incremento hardware

load balancing Tor-aware

possono eliminare rapidamente questi colli di bottiglia.

8. Impatti su SOC, blue team e governance IT

Difesa tecnica

aumento di malware commodity personalizzato

minor riuso di signature note

maggiore varietà nei payload

Detection

più difficile basarsi su IOC statici

maggiore importanza di:

behavioral analysis

anomaly detection

zero trust

Governance

necessità di:

AI risk assessment

policy interne sull’uso di LLM

formazione tecnica avanzata

9. DIG AI non è il problema, è il sintomo

Dal punto di vista ingegneristico, DIG AI dimostra che:

i LLM possono essere facilmente “deragliati”

i guardrail non sono una proprietà intrinseca del modello

l’accessibilità anonima è il vero fattore critico

Anche se DIG AI venisse spento, altri sistemi equivalenti emergeranno.

Il paradigma è ormai chiaro: l’AI offensiva è entrata nella fase industriale.

Conclusione tecnica

DIG AI rappresenta un caso di studio fondamentale per chi opera nella sicurezza informatica:

non è sofisticato

non è innovativo dal punto di vista algoritmico

è estremamente efficace dal punto di vista operativo

Per aziende, PA e infrastrutture critiche, ignorare questa evoluzione significa progettare la sicurezza su un modello di minaccia ormai superato.

La domanda non è se questi strumenti verranno usati su larga scala, ma quanto velocemente i sistemi difensivi riusciranno ad adattarsi.